8 lignes pour utiliser ChatGPT (openAI) pour mettre en place une aide rapide pour vos utilisateurs grâce à vos documents déja existants.

Vous avez des tonnes de documentation qui dorment qui décrivent avec précisions comment vos utilisateurs doivent interagir avec votre toute nouvelle application ?

Et vous avez un support ou un service client qui s’amuse à chercher dans ces docs les réponses aux questions envoyées.

Tous le monde perd du temps : vos équipes support, vos utilisateurs…

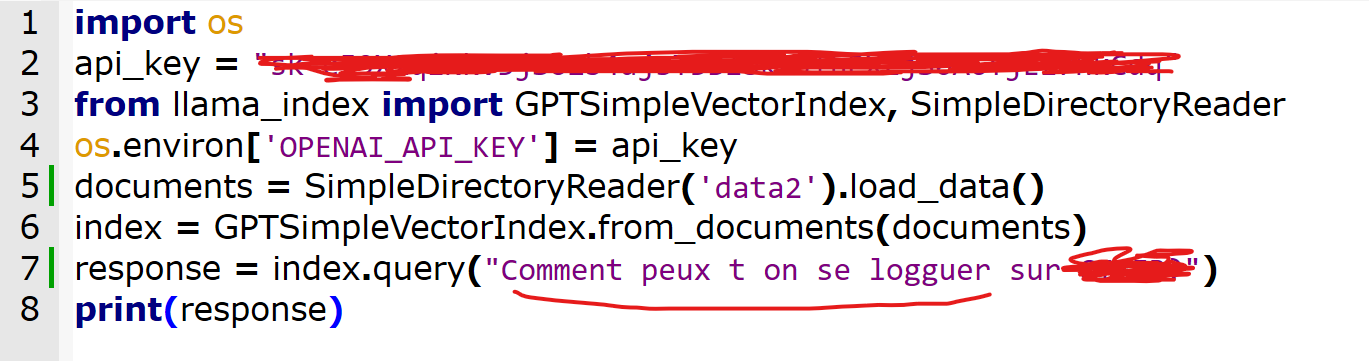

Je vous propose de traiter le problème en 8 lignes de code grâce à Python, OpenAi, et LLama_index.

C’est simple : le modèle chatGPT va parcourir vos documents que vous mettrez en vrac (fonctionne pour le texte, le powerpoint, les pdf….) à un endroit et va les comprendre. ça c’est la magie de Llama_index.

Ensuite vous pourrez juste faire une recherche en utilisant le language +naturel+ donc en parlant votre langue.

La documentation peut être en Français et la réponse en Italien en utilisant les capacités de traduction de chatGPT si jamais donc la langue du document original ne compte plus. (pas fait dans la démo après).

C’est simple et cela prend quelques minutes pour un développeur pour mettre en place le backoffice en un proof of concept, rapide et efficace…evidemment il faudra faire une UX pour accueillir l’utilisateur etc.

- Etape 1 : Vous mettez vos documents dans un repertoire /data

- Etape 2 : vous installez les libs : llama_index dans votre python préféré

Et vous tapez ces 8 lignes de code

Il va vous demander aussi d’installer des libs additionnelles pour lire les PDFs.

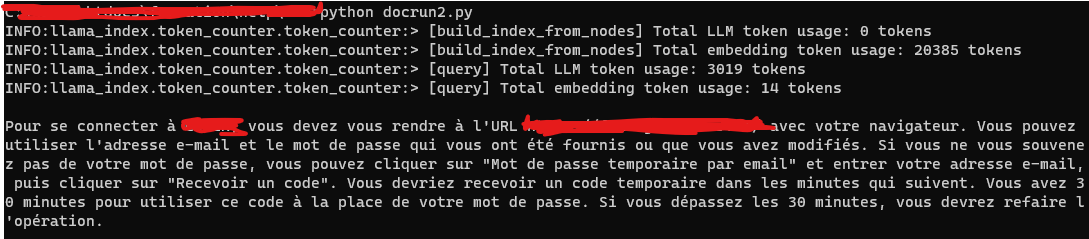

3. Etape 3 : Vous lancez votre script en simulant la question “comment peux-t-on se logguer sur …”

Et l’application sort immédiatement une réponse à partir de vos documents :

Bien entendu le modèle ChatGPT (openai) présente des enjeux de sécurité qui ne sont pas à négliger et envoyer “dans l’espace” des données très sensibles est un vrai problème.

On parlera donc plutôt d’une documentation déja accessible publiquement dans ce cas.